ダンスの脳内表現に生成AIで迫る ――音楽・身体・感情にかかわる脳応答を包括的モデル化―― 研究成果

発表のポイント

◆ダンス映像視聴中にfMRIで計測した脳応答を、音楽と身体運動を統合した「クロスモーダル特徴」(深層生成モデル由来)で説明できることを示しました。低次の運動特徴や音響特徴に比べ、クロスモーダル特徴のほうが人間の脳活動をよく説明することを発見しました。

◆美しさ、躍動感などダンス鑑賞中に生じる数十項目にわたる感情表現をモデル化することで、ダンス視聴中に生じる感情の違いに応じて異なる神経パターンが得られることを発見しました。

◆熟達ダンサーはダンス未経験者に比べて脳の広範にわたってダンスの情報が表現されている一方、熟達ダンサーの方が脳内表現の個人差が大きいことを定量的に示しました。

◆本研究は神経美学・芸術科学やダンス教育・訓練支援、人間とAIの創造的インタラクション設計に資する基盤知見を提供します。

◆美しさ、躍動感などダンス鑑賞中に生じる数十項目にわたる感情表現をモデル化することで、ダンス視聴中に生じる感情の違いに応じて異なる神経パターンが得られることを発見しました。

◆熟達ダンサーはダンス未経験者に比べて脳の広範にわたってダンスの情報が表現されている一方、熟達ダンサーの方が脳内表現の個人差が大きいことを定量的に示しました。

◆本研究は神経美学・芸術科学やダンス教育・訓練支援、人間とAIの創造的インタラクション設計に資する基盤知見を提供します。

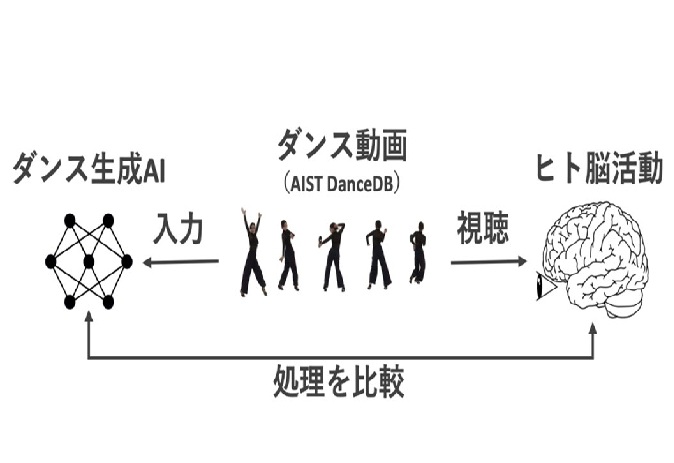

ヒトと生成AIのダンスに対する情報処理を、世界で初めて定量的に比較

概要

東京大学大学院人文社会系研究科の今水 寛教授、若林 実奈大学院生(当時)、名古屋工業大学大学院工学研究科の高木 優准教授、神戸大学大学院人間発達環境学研究科の清水 大地助教、産業技術総合研究所人間情報インタラクション研究部門の大畑 龍研究員らは、自然なダンス映像を視聴している参加者のfMRI脳活動データと、音楽からダンスの振り付けを生成するクロスモーダル深層生成モデル(EDGE)から得たTransformerの特徴量を結び付け、ダンスが脳内でどのように表現されるかを定量的に明らかにしました。

本研究では、ダンス動画データベース(AIST Dance DB)に含まれるストリート/ジャズを含む多様なダンス動画を視聴する14名(熟達ダンサーを含む)の脳活動を計測し、ダンスに含まれる特徴から、脳活動を予測する「エンコーディングモデル」を構築しました。その結果、音と動きを統合したクロスモーダル特徴が、運動・音響特徴単体よりもダンスが誘発する脳活動を良く説明することを示しました。さらにエンコーディングモデルをコンピュータ上の「脳活動シミュレータ」として用いることで、異なる感情を喚起するダンスが異なる神経パターンをもたらすことを定量化しました。熟達ダンサーではダンス特徴による説明範囲が広い一方、個人差が大きいことも見いだされました。これらの成果は、動き・音楽・熟達度が美的・感情体験を形作る仕組みの理解に資するものです。

東京大学大学院人文社会系研究科の今水 寛教授、若林 実奈大学院生(当時)、名古屋工業大学大学院工学研究科の高木 優准教授、神戸大学大学院人間発達環境学研究科の清水 大地助教、産業技術総合研究所人間情報インタラクション研究部門の大畑 龍研究員らは、自然なダンス映像を視聴している参加者のfMRI脳活動データと、音楽からダンスの振り付けを生成するクロスモーダル深層生成モデル(EDGE)から得たTransformerの特徴量を結び付け、ダンスが脳内でどのように表現されるかを定量的に明らかにしました。

本研究では、ダンス動画データベース(AIST Dance DB)に含まれるストリート/ジャズを含む多様なダンス動画を視聴する14名(熟達ダンサーを含む)の脳活動を計測し、ダンスに含まれる特徴から、脳活動を予測する「エンコーディングモデル」を構築しました。その結果、音と動きを統合したクロスモーダル特徴が、運動・音響特徴単体よりもダンスが誘発する脳活動を良く説明することを示しました。さらにエンコーディングモデルをコンピュータ上の「脳活動シミュレータ」として用いることで、異なる感情を喚起するダンスが異なる神経パターンをもたらすことを定量化しました。熟達ダンサーではダンス特徴による説明範囲が広い一方、個人差が大きいことも見いだされました。これらの成果は、動き・音楽・熟達度が美的・感情体験を形作る仕組みの理解に資するものです。

論文情報

Yu Takagi, Daichi Shimizu, Mina Wakabayashi, Ryu Ohata, Hiroshi Imamizu, "Cross-modal deep generative models reveal the cortical representation of dancing," Nature Communications: 2025年11月19日, doi:10.1038/s41467-025-65039-w.

論文へのリンク (掲載誌 )

)