深層学習の原理を説明する新理論――ニューラルネットワークのエネルギー曲面上の滞留現象研究成果

掲載日:2023年1月24日

発表者

今泉 允聡(東京大学 大学院総合文化研究科 広域科学専攻 准教授)

Johannes Schmidt-Hieber(University of Twente, Professor)

発表のポイント

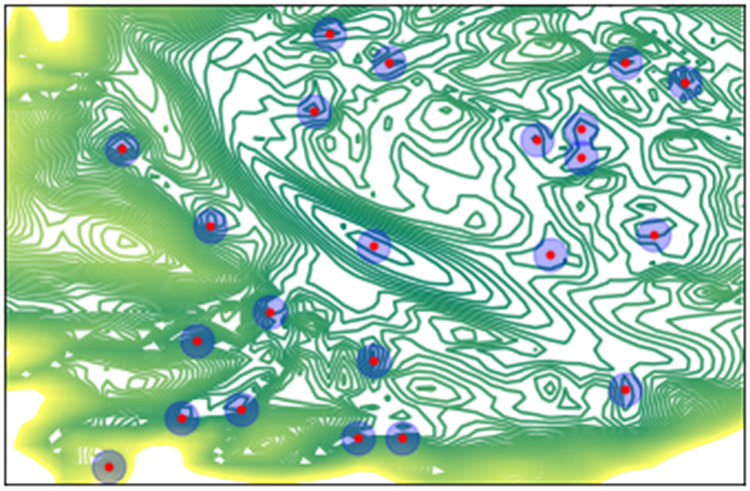

- 深層学習が過学習を起こさない原理を、ニューラルネットワークがエネルギー曲面上で滞留する数学的理論を開発して説明した。

- 深層学習が大自由度にも関わらず過学習しない原理は長年の未解明点であり、これを説明する理論を開発した。

- 深層学習を効率的に制御するための理論の発展や、アルゴリズム開発・ネットワーク設計などへの工学的応用が期待される。

発表概要

東京大学大学院総合文化研究科の今泉允聡准教授、University of TwenteのJohannes Schmidt-Hieber教授による研究チームは、ニューラルネットワークがエネルギー曲面上で"滞留"という現象を起こすことを数学的に記述し、深層学習が過学習を起こさない原理を説明する新理論を開発しました。深層学習が大量のパラメータを持ちながらも過学習をしない理由は、近年多くの仮説が提起されつつも未だに十分には明らかにされていません。今回の成果は、滞留の概念を用いてアルゴリズムの確率的挙動を記述することで、深層学習が汎用的な知識を獲得する現象への新しい理論的基礎づけを与えました。今後は、より具体的な深層学習の理論の発展や、深層学習の高速化につながるアルゴリズムの開発などにつながることが期待されます。

本研究成果は、2023年1月20日(米国東部時間)に米国科学誌「IEEE Transactions on Information Theory」のオンライン版に掲載されました。

発表詳細は大学院総合文化研究科のページからご覧ください。

論文情報

Masaaki Imaizumi*, Johannes Schmidt-Hieber, "On Generalization Bounds for Deep Networks based on Loss Surface Implicit Regularization," IEEE Transactions on Information Theory: 2023年1月20日, doi:10.1109/TIT.2022.3215088.

論文へのリンク (掲載誌 )

)